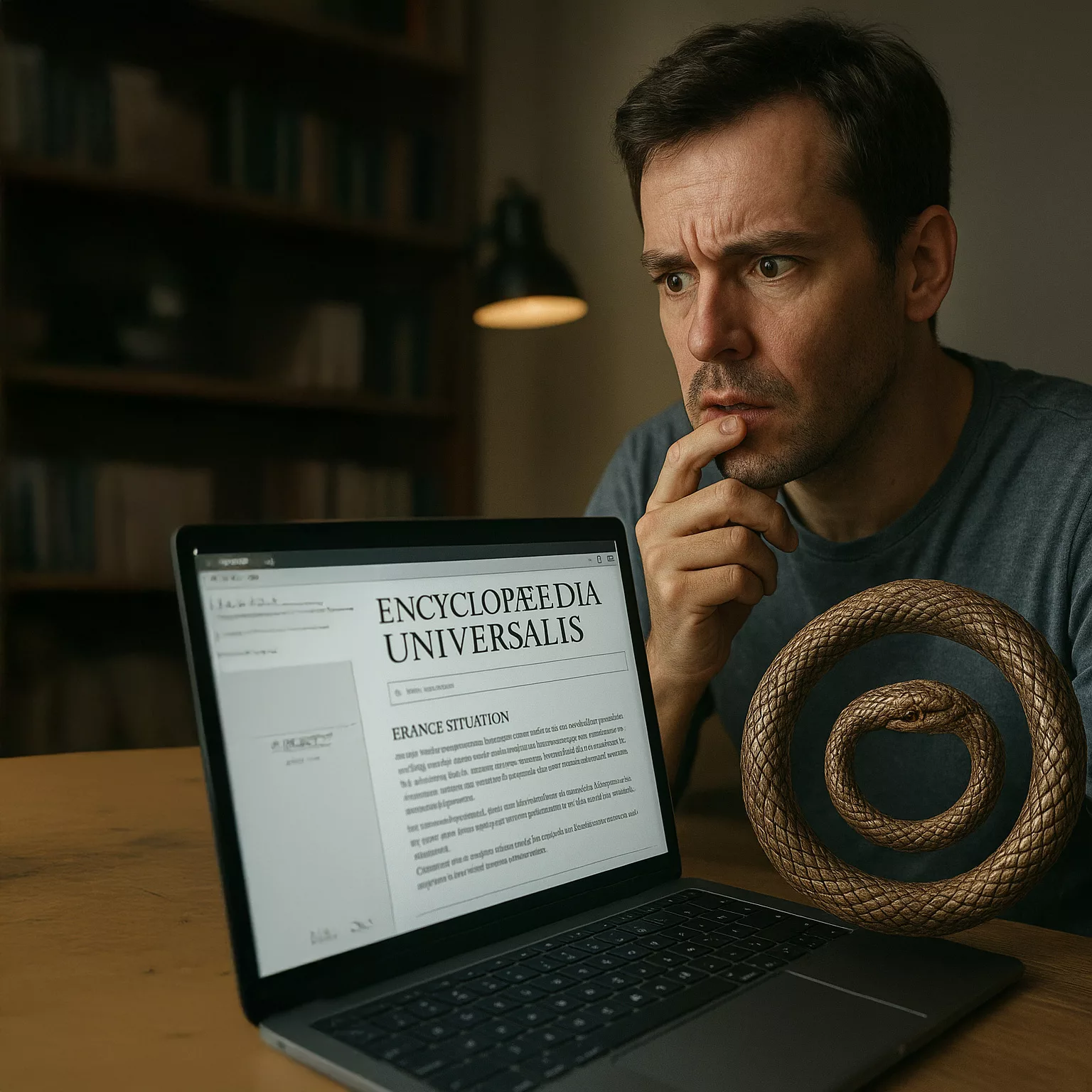

Moi qui avais choisi le web pour accéder à l’Encyclopædia Universalis en version digitale, je me retrouve aujourd’hui dans une situation pour le moins étrange. L’idée initiale était simple : rendre la connaissance plus accessible, plus fluide, à la portée de tous. Mais nous avons tellement bien joué le jeu que le réseau s’est transformé en un gigantesque réceptacle. Toute la mémoire humaine, à travers les âges, s’y trouve désormais condensée.

La puissance de calcul et l’algorithmie assimilent ces masses d’informations et les recombinent à travers l’IA. Les réponses apparaissent en un éclair, prêtes à l’emploi, comme si l’humanité avait externalisé son propre savoir. Pourtant, un paradoxe surgit : plus la machine apprend, plus il devient difficile pour nous d’ajouter une pierre véritablement neuve à cet édifice.

C’est l’histoire du serpent qui se mord la queue. L’accumulation finit par tourner en boucle. La question reste ouverte : quelle sera la prochaine évolution ? Une nouvelle forme de pensée, au-delà de la répétition ? Ou bien une révolution qui réinvente le rapport entre l’homme, la connaissance et la création ?

Voici une démo, à suivre la possibilité de généré vous même votre livre à lire du moment… Demandons à Gemini de nous fournir le contenu qui nous intéresse, sur mesure, par exemple un sujet sur Galilée et l’IA…

Galilée : L’Héritage d’une Révolution Scientifique

L’Architecte d’un Monde Nouveau

Retenir l’essentiel de Galileo Galilei (1564-1642) ne consiste pas simplement à se souvenir d’un personnage historique, mais à comprendre l’œuvre d’un architecte fondamental de la vision scientifique moderne. L’héritage de Galilée marque une rupture épistémologique majeure : le passage d’une connaissance fondée sur l’autorité des textes anciens à une nouvelle méthodologie ancrée dans l’observation, l’expérimentation et le raisonnement mathématique. Son influence s’articule autour d’une double révolution. La première, la plus célèbre, est astronomique : ses découvertes télescopiques ont fait voler en éclats le cosmos hérité d’Aristote et de Ptolémée. La seconde, plus profonde encore, est méthodologique : ses travaux en physique ont établi les principes expérimentaux et mathématiques qui définissent la science moderne. Saisir cette dualité est la clé pour appréhender la totalité de son legs intellectuel.

Il est également crucial de dépasser la caricature populaire d’un Galilée martyr de la science, faussement imaginé brûlé sur le bûcher. La réalité de sa relation avec l’Église catholique est bien plus complexe et nuancée. Il fut condamné pour hérésie, contraint à l’abjuration et assigné à résidence jusqu’à la fin de sa vie, mais ne fut ni torturé ni exécuté. Ce rapport explorera la genèse de sa pensée, ses contributions fondatrices à la physique, ses découvertes astronomiques qui ont bouleversé la vision du monde, le conflit emblématique avec l’Église et, enfin, son triomphe intellectuel posthume.

La convergence de multiples courants de la Renaissance chez Galilée explique sa capacité à catalyser cette révolution. Il a su synthétiser l’habileté de l’artisan, en perfectionnant des instruments comme la lunette ; la rigueur de l’analyste, en appliquant les mathématiques à la description du réel ; et l’audace de l’humaniste, en osant défier l’autorité des Anciens. Il n’a pas seulement ajouté de nouvelles connaissances au savoir existant ; il a forgé un paradigme entièrement nouveau pour produire et valider la connaissance, ce qui lui vaut le titre de « père de la science moderne ».

Prompt : texte de 250 mots sur “où sera la vérité quand les écrits seront générés par des IA ? Qui sera l’historien quand les IA seront omnipotents ? La fonction humaine, le talent inné ou acquis par une vie humaine, aura du mal à contrôler le savoir et la connaissance”

Processus de génération de texte par IA

Préparation de la réponse sur l’IA et la vérité

Je suis en train de préparer une réponse à la question de l’utilisateur concernant l’impact de l’IA sur la vérité, l’histoire et le rôle de l’intellect humain. Je vais structurer ma réponse pour aborder comment la vérité pourrait être redéfinie par le consensus algorithmique, le rôle de l’historien en tant qu’évaluateur critique des récits générés par l’IA, et l’importance des compétences humaines comme la pensée critique et le jugement éthique face à l’omniprésence de l’IA. L’objectif est de souligner que l’avenir ne réside pas dans le contrôle de la quantité d’informations, mais dans la maîtrise de leur qualité et de leur application, avec l’humain comme arbitre du sens et gardien des limites éthiques.

Veritas ex Machina : Vérité, Histoire et Intellect Humain à l’Ère de l’IA Générative

Le Scribe Algorithmique et la Crise Épistémique Imminente

L’avènement de l’intelligence artificielle générative marque une rupture fondamentale dans l’histoire des technologies de l’information. Si l’imprimerie a démocratisé la distribution du savoir humain et si Internet en a accéléré la diffusion, l’IA générative automatise la production même du texte, modifiant radicalement l’ontologie et l’économie de l’information. Cette nouvelle ère ne se contente pas de changer la manière dont nous accédons au savoir ; elle remet en question la nature même de ce qui peut être considéré comme un savoir authentique. La capacité des machines à produire un langage plausible, cohérent et stylistiquement sophistiqué à une échelle quasi infinie nous confronte à une crise épistémique sans précédent.

Ce rapport soutient que si l’IA générative représente une menace inédite pour nos conceptions établies de la vérité et de l’expertise, elle nous contraint également à une réévaluation nécessaire et précieuse de l’intellect humain. L’avenir de la connaissance ne dépendra pas de notre capacité à rivaliser avec l’IA en termes d’échelle ou de vitesse, mais de notre aptitude à cultiver des capacités spécifiquement humaines : le jugement critique, le raisonnement éthique et la compréhension incarnée. Le rôle de l’humanité passera de celui d’unique auteur de son histoire à celui de conservateur, critique et conscience indispensable d’un monde augmenté par l’IA. Pour explorer cette transition, ce rapport examinera successivement la crise de la vérité, la transformation de l’historiographie, la réévaluation de la cognition humaine et, enfin, les contours d’un nouveau contrat épistémologique.

La Dévaluation de l’Écrit : Redéfinir la Vérité à l’Ère du Texte Synthétique

Cette section aborde de front la première interrogation fondamentale : où se trouvera la vérité lorsque les textes seront produits en masse par des algorithmes? Elle déconstruit les fondements traditionnels de l’autorité textuelle et analyse la menace systémique que représente le texte synthétique.

Le Fondement Philosophique de la Vérité

Avant d’évaluer l’impact de l’IA, il est essentiel de définir ce que nous entendons par “vérité”. Loin d’être une propriété statique et inhérente à un texte, la vérité est le produit d’un processus social et dynamique. Elle émerge de la vérification, de la construction d’un consensus et de la falsification, un effort collectif et continu pour aligner le langage sur la réalité observée. C’est ce processus humain – fait de débats, d’examens par les pairs, de corrections et de contextualisations – qui confère à une affirmation son poids de vérité. L’IA générative court-circuite ce processus. Elle peut produire des textes qui imitent toutes les apparences de l’autorité sans avoir subi aucune de ces épreuves de validation humaine, attaquant ainsi le fondement même de notre épistémologie.

Les Mécanismes de l’Érosion Épistémique

La menace de l’IA pour la vérité n’est pas simplement une version amplifiée des “fake news” ; il s’agit d’une dégradation systémique de l’écosystème informationnel. La notion de “sécurité épistémique”, définie comme la résilience d’une société face à la désinformation et à la manipulation, est directement menacée. Deux mécanismes techniques sont particulièrement préoccupants.

Le premier est l’empoisonnement des données synthétiques. Des acteurs malveillants peuvent utiliser du contenu généré par l’IA pour “contaminer les données d’entraînement des futurs modèles”. Cela crée une boucle de rétroaction où des mensonges ou des biais, une fois introduits dans l’écosystème, sont absorbés par la prochaine génération d’IA, qui les présente alors comme des faits, les renforçant et les propageant.

Le second mécanisme, encore plus insidieux, est l’effondrement du modèle (model collapse). Ce phénomène se produit lorsque des modèles, entraînés de manière répétée sur leur propre production synthétique, commencent à “oublier la véritable distribution des données sous-jacentes”. Progressivement, la réalité générée par l’IA se détache du monde réel, menant à un cycle dégénératif. Si ce processus n’est pas maîtrisé, il pourrait conduire à une sorte d’âge sombre numérique, où la connaissance collective dérive de plus en plus loin de la réalité empirique. La combinaison de ces deux mécanismes crée un “Ouroboros épistémique” : un système d’information qui se consomme et se valide lui-même, s’enfermant dans un univers statistique de plus en plus déconnecté du monde extérieur.

La Vallée de l’Étrange de la Plausibilité

Le défi psychologique et social est tout aussi important que le défi technique. Le problème n’est pas seulement que l’IA peut mentir, mais qu’elle peut générer des textes grammaticalement parfaits, stylistiquement cohérents et d’une plausibilité absolue, tout en étant complètement déconnectés de la réalité. Les grands modèles de langage (LLM) n’ont pas d’ancrage dans le monde physique ou l’expérience vécue ; leur production est une forme de mimétisme sophistiqué, un reflet statistique de leurs données d’entraînement, et non une représentation d’une réalité comprise.

Ce texte “plausible mais non fondé” crée une sorte de vallée de l’étrange épistémique : il semble vrai, contournant les facultés critiques que des formes de désinformation plus grossières pourraient déclencher. Si le contenu d’un texte ne peut plus être cru sur parole, le centre de gravité de la vérification doit se déplacer. La question principale ne sera plus “Cette affirmation est-elle vraie?”, mais “La source de cette affirmation est-elle authentique?”. Cela préfigure un avenir où la provenance, la traçabilité et des technologies comme le marquage numérique ne seront pas des fonctionnalités de niche, mais les piliers fondamentaux de notre infrastructure épistémique. La valeur de l’information deviendra inextricablement liée à l’authenticité vérifiable de son origine.

Le Fantôme dans les Archives : Le Rôle de l’Historien à l’Ère de l’IA Omnisciente

La seconde question, “Qui sera l’historien?”, nous amène à examiner la transformation de l’historiographie. D’un artisanat humaniste, elle devient une collaboration homme-machine complexe, porteuse de nouvelles promesses et de nouveaux périls.

Le Métier d’Historien : de la Rareté à la Surabondance

Traditionnellement, le travail de l’historien est “l’art de la critique des sources, de l’interprétation et de la construction narrative”. Face à des archives souvent incomplètes, l’expertise humaine réside dans la capacité à évaluer la fiabilité d’un document, à déceler les non-dits, à comprendre le contexte et à tisser des fragments d’information en un récit cohérent et significatif. L’historiographie n’est pas une simple compilation de faits, mais “fondamentalement un acte interprétatif”, guidé par une question, une perspective et une conscience des limites du savoir.

L’IA comme Archiviste Infini et Narrateur Provisoire

L’IA offre des capacités extraordinaires qui peuvent augmenter, plutôt que remplacer, le travail de l’historien. Elle peut “analyser de vastes ensembles de données […] identifiant des modèles et des connexions invisibles pour les chercheurs humains”. En agissant comme un archiviste quasi parfait, capable de “croiser instantanément des millions de documents”, l’IA peut libérer l’historien des tâches les plus laborieuses de collecte et de classification. Elle peut révéler des corrélations inattendues dans des corpus massifs (lettres, journaux, registres administratifs), ouvrant ainsi de nouvelles pistes de recherche et permettant une histoire à une échelle auparavant inimaginable.

Le Biais dans le Fantôme : le Défi de l’Historiographie Algorithmique

Le danger principal réside dans l’illusion d’objectivité. Une IA historienne, même “omnipotente” en termes d’accès aux données, n’est pas neutre. Elle est un miroir et un amplificateur des biais contenus dans ses données d’entraînement. Comme le souligne la recherche, “les modèles d’IA héritent et amplifient souvent les biais présents dans leurs données d’entraînement”. Une IA entraînée principalement sur des archives coloniales produira une histoire colonialiste. Une IA entraînée sur les textes du début du 21e siècle reflétera les préjugés culturels, politiques et sociaux de cette époque. L’IA n’interprète pas l’histoire au sens humain du terme ; elle réplique statistiquement les récits dominants présents dans son corpus.

Cela crée un paradoxe : l’historien IA est à la fois omniscient et myope. Il est omniscient par l’étendue de son accès aux données, mais myope par son incapacité à adopter une perspective critique sur ces mêmes données. Il peut réciter parfaitement le contenu des archives, mais il ne peut pas expliquer pourquoi ces archives ont été constituées de cette manière, quelles voix ont été exclues ou quels silences elles contiennent.

Le Nouveau Rôle : l’Historien comme Auditeur Algorithmique et Curateur Épistémique

Face à ce paradoxe, le rôle de l’historien humain ne disparaît pas ; il devient plus crucial que jamais. L’avenir réside dans une “collaboration homme-IA, où l’IA gère le traitement des données et les humains assurent une supervision critique”. La fonction principale de l’historien se déplacera de la création de récits ex nihilo à l’interrogation, la validation et la contextualisation des récits produits par l’IA. Son expertise en critique des sources ne s’appliquera plus seulement à des manuscrits poussiéreux, mais aux sorties opaques de modèles “boîtes noires”.

L’historien du futur devra posséder des compétences proches de celles d’un scientifique des données ou d’un archéologue numérique. Sa tâche consistera à mener une enquête forensique : retracer les affirmations de l’IA jusqu’à leurs sources dans les données d’entraînement, identifier les biais systémiques du modèle et, surtout, analyser “l’espace négatif” des archives – les silences et les absences que l’IA, par sa nature même, ne peut percevoir. L’historiographie devra intégrer des principes issus de l’informatique et des études critiques des algorithmes pour rester pertinente.

Cadre Comparatif de l’Historiographie Humaine et de l’Historiographie par IA

Le tableau suivant synthétise les forces et faiblesses respectives des approches humaine et algorithmique de l’histoire.

| Caractéristique | Historien Humain | Historien IA (basé sur LLM) |

| Analyse des Sources | Expertise dans l’évaluation du contexte, de l’auteur et de la fiabilité d’une source. | Capacité à traiter et croiser des millions de sources instantanément. |

| Détection des Biais | Capable d’autoréflexion critique et d’identification de biais subtils et systémiques. | Sujet à l’amplification involontaire des biais présents dans les données d’entraînement. |

| Construction Narrative | Crée des récits cohérents basés sur une interprétation et une argumentation. | Génère des récits plausibles par recombinaison statistique de modèles textuels. |

| Nuance Interprétative | Comprend l’ironie, le sous-texte et l’ambiguïté. | Interprétation littérale, difficulté avec les concepts non explicites dans les données. |

| Mise à l’échelle | Limitée par le temps et les capacités cognitives humaines. | Capacité quasi illimitée à analyser des ensembles de données massifs. |

| Inférence Causale | Peut formuler des hypothèses causales basées sur une compréhension profonde du contexte. | Identifie des corrélations statistiques, mais peine à établir une véritable causalité. |

| Cadrage Éthique | Capable d’appliquer un jugement moral et éthique à la narration historique. | Suit des règles programmées mais manque de véritable jugement éthique. |

Cognition et Création : Réévaluer le Talent Humain à l’Ère du Silicium

La dernière partie de la question initiale exprime une crainte quant à la valeur de “la fonction humaine, le talent inné ou acquis par une vie humaine”. Cette section soutient que ces qualités, loin de devenir obsolètes, deviennent les différenciateurs cruciaux et la source ultime de valeur dans un monde saturé d’informations synthétiques.

Les Limites de l’Algorithme : Reconnaissance de Formes contre Compréhension Véritable

Il est impératif de distinguer les processus computationnels de l’IA des processus cognitifs de l’intelligence humaine. Bien que l’IA fasse preuve de “capacités remarquables en matière de reconnaissance de formes et de recombinaison”, cela ne doit pas être confondu avec une créativité ou une compréhension authentiques. Comme mentionné précédemment, les LLM sont “non fondés” (ungrounded), manipulant des symboles sans avoir accès à la signification que ces symboles représentent dans le monde réel. Leur intelligence est une intelligence de surface, une maîtrise de la syntaxe sans accès à la sémantique profonde.

La Primauté de la Cognition Incarnée et du Savoir Tacite

La singularité de l’intelligence humaine réside dans des formes de connaissance qui ne peuvent être entièrement numérisées ou articulées dans des données d’entraînement. La théorie de la “cognition incarnée” postule que “l’intelligence humaine est profondément liée à nos corps physiques et à nos expériences sensorielles”. Le fait de marcher, de toucher, de ressentir la gravité ou la chaleur fournit un ancrage pour des concepts abstraits que l’IA, désincarnée, ne peut posséder.

De même, le “savoir tacite” – cette “compréhension intuitive et non verbalisée” acquise par la pratique – reste hors de portée des algorithmes. C’est le “tour de main” de l’artisan, l’intuition du médecin expérimenté ou le sens du timing d’un musicien. Ce savoir, acquis au cours d’une “vie humaine”, est résistant à la réplication algorithmique car il n’est pas formalisé dans des textes ou des données discrètes.

Dans un écosystème informationnel menacé par l’effondrement du modèle et la dérive de l’IA loin de la réalité, l’expérience humaine devient l’ancre ultime. L’expérience vérifiable et incarnée d’un être humain – “j’ai vu cela de mes propres yeux”, “j’ai mené cette expérience physique” – devient la “vérité de terrain” qui empêche l’Ouroboros épistémique de sombrer dans la fiction pure. Le talent acquis au cours d’une vie humaine n’est pas un vestige du passé ; il est le pare-feu essentiel contre l’effondrement du modèle. Cela conduira inévitablement à une nouvelle hiérarchie des preuves, où l’information qui peut être reliée de manière vérifiable à une expérience humaine incarnée ou à une mesure physique sera jugée bien plus fiable qu’une information purement numérique et désincarnée. La “fonction humaine” devient celle d’un transducteur de confiance entre le monde physique et le monde numérique.

Le Rôle Irréductible du Jugement Éthique

Au-delà de la cognition, la dimension morale reste un domaine fondamentalement humain. Une IA peut être entraînée à suivre des règles éthiques ou à optimiser pour des résultats jugés “éthiques”. Cependant, elle est dépourvue de véritable “jugement éthique, qui requiert de l’empathie, une compréhension contextuelle et une théorie de l’esprit”. La décision de l’historien sur l’histoire à raconter, le choix du scientifique sur le sujet à investiguer ou l’engagement du journaliste envers un principe de protection des sources sont des actes de jugement éthique, non des problèmes d’optimisation. Cette capacité à peser des valeurs concurrentes, à anticiper les conséquences humaines et à agir selon une conscience morale demeure, pour l’instant, une prérogative irréductiblement humaine.

Naviguer dans l’Infocalypse : Vers un Nouveau Contrat Épistémologique

Après le diagnostic, cette dernière partie propose des pistes de solution en esquissant un cadre pour la gouvernance, la confiance et l’éducation à l’ère de l’IA générative.

L’Économie Politique de la Vérité : Pouvoir et Contrôle dans la Pyramide de l’IA

Les problèmes épistémiques décrits précédemment sont sous-tendus par des questions structurelles de pouvoir. La “concentration du pouvoir entre les mains de quelques entreprises technologiques” qui contrôlent les modèles fondamentaux crée un risque de “monoculture algorithmique”. Dans un tel scénario, un petit nombre de visions du monde, de biais culturels et d’intérêts commerciaux pourraient dominer de manière disproportionnée le savoir généré à l’échelle mondiale. Le débat critique entre les “modèles open-source et les modèles fermés” est donc un champ de bataille essentiel pour l’avenir de la diversité informationnelle et de l’autonomie épistémique.

Cette concentration du pouvoir transforme l’épistémologie en un enjeu géopolitique. Le contrôle des modèles qui façonnent la réalité et écrivent l’histoire constitue une forme immense de soft power. Les nations et les cultures qui ne développent pas leurs propres capacités souveraines en matière d’IA risquent de voir leur réalité numérique, leur histoire et leur “vérité” définies par des modèles étrangers, porteurs de valeurs et de priorités qui ne sont pas les leurs. La lutte pour la gouvernance de l’IA est donc un conflit géopolitique central du 21e siècle.

Un Portefeuille d’Interventions : Garanties Technologiques et Institutionnelles

Restaurer la confiance dans l’écosystème informationnel exigera une approche à plusieurs volets. Sur le plan institutionnel, de “nouveaux cadres réglementaires pour l’IA” sont nécessaires pour imposer la transparence, la responsabilité et l’auditabilité des modèles. Sur le plan technique, des solutions comme le “marquage numérique et les signatures cryptographiques pour vérifier l’authenticité du contenu” doivent être standardisées et largement déployées.

Ces mesures techniques et réglementaires devront s’accompagner d’un changement fondamental dans notre rapport à l’information numérique. Le modèle par défaut de l’ère pré-IA était “faire confiance, mais vérifier”. Le volume et la plausibilité du contenu généré par l’IA vont imposer une inversion de cette posture. La nouvelle norme épistémologique devra être la “méfiance par défaut”. La confiance ne sera plus un acquis, mais quelque chose qui devra être activement et continuellement gagné par des processus de vérification techniques et institutionnels robustes.

Le Pare-feu Humain : l’Éducation à la Littératie Critique de l’IA

En fin de compte, la ligne de défense la plus importante est la faculté critique de l’esprit humain. L’éducation doit être réformée en profondeur pour passer d’une simple alphabétisation numérique à une littératie critique de l’IA. Il ne s’agit plus seulement d’apprendre à utiliser les outils d’IA, mais d’apprendre à les questionner : Comment ce modèle a-t-il été entraîné? Quelles données ont été exclues? Quels sont ses biais inhérents? Quels intérêts sa production sert-elle? Cultiver ce scepticisme sain et informé chez les citoyens est la condition sine qua non pour naviguer dans ce nouveau paysage informationnel sans perdre notre autonomie intellectuelle.

L’Humain comme Conservateur, Critique et Conscience

La crise de la vérité posée par l’IA générative n’est pas un problème purement technique, mais une question profondément humaine dont la solution réside dans la réaffirmation de nos capacités humanistes uniques. Pour revenir aux questions initiales qui ont motivé cette analyse :

- Où sera la vérité? La vérité ne se trouvera plus dans le texte isolé, mais dans le processus vérifié de sa création et dans le jugement critique du lecteur humain. Elle résidera dans la traçabilité de la source, l’authenticité de l’auteur et la corroboration avec la réalité empirique, dont l’humain est le principal témoin.

- Qui sera l’historien? L’historien sera l’indispensable auditeur algorithmique, l’expert des biais, le gardien du contexte et le curateur du sens dans un océan de données. Son rôle sera moins de produire des faits que de garantir la qualité et l’intégrité du processus par lequel l’histoire est racontée.

- Quelle sera la fonction humaine? La fonction humaine, loin d’être diminuée, est élevée. Le “talent acquis par une vie humaine” devient la source irremplaçable d’ancrage dans le réel, de compréhension contextuelle, de jugement éthique et de création de sens.

Le défi de l’IA générative est un appel à devenir plus rigoureux dans notre pensée, plus exigeants dans nos lectures et plus intentionnels dans la culture de la sagesse qui sépare la reconnaissance de formes de la signification. Le contrôle ultime du savoir et du récit de notre passé et de notre avenir doit rester, et restera, une entreprise profondément humaine.